Innehållsförteckning:

- Författare John Day day@howwhatproduce.com.

- Public 2024-01-30 12:39.

- Senast ändrad 2025-01-23 15:10.

Tanken/drivkraften bakom genomförandet av detta projekt var att hjälpa människor som har svårt att kommunicera med tal och kommunicera med handgester eller mer populärt kallat amerikanskt signerat språk (ASL). Detta projekt kan vara ett steg mot att ge dessa människor en möjlighet att arbeta med andra människor, som inte kan förstå teckenspråket, i en samarbetsmiljö. Detta projekt kommer också att göra det möjligt för dem att hålla offentliga tal utan att använda en verklig mänsklig översättare. Till att börja med försökte jag bara upptäcka några av de enklare gesterna som alfabet A, B, I, etc och har också tilldelat vissa gester till vanliga ord/hälsningar som "Hej", "God morgon", etc.

Steg 1: Kretsmontering

Steg 2: Projektdetaljer

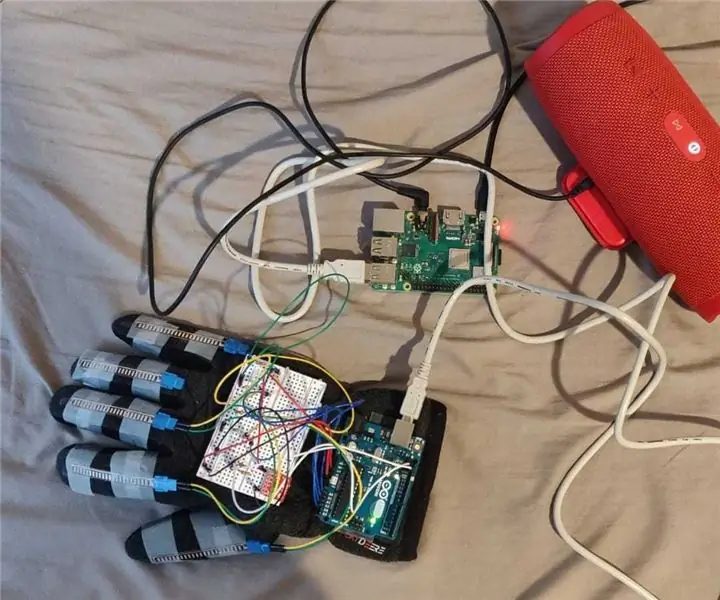

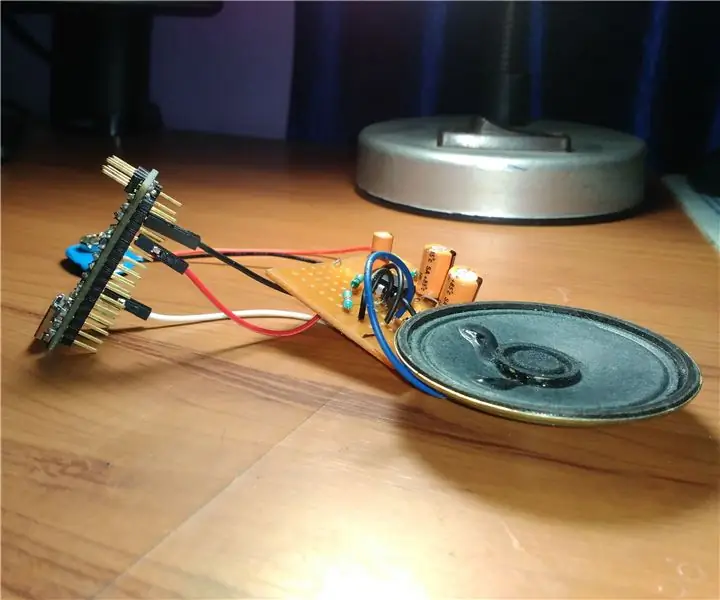

Detta projekt innehåller en bärbar handske med 4 flex -sensorer som sitter fast/inbäddade i handsken - en vardera för små, mitten, pekfingrar och tumme. Flex -sensorn användes inte för ringfinger på grund av begränsningar i tillgängligheten av analoga ingångspinnar på Arduino Uno R3 och generellt på grund av bristande oberoende rörelse som visas av fingret på teckenspråk. En MMA8452Q -accelerometer används också som sitter fast på baksidan av handflatan för att mäta handens orientering. Inmatning från dessa sensorer analyseras och används för att känna av gesten. När gesten känns av sparas motsvarande tecken/meddelande i en variabel. Dessa tecken och meddelanden fortsätter att sammanfoga tills en viss förutbestämd gest görs som indikerar att meningen är slutförd. När den speciella gesten upptäcks skickas den sparade meningssträngen till Raspberry Pi via USB -kabel av Arduino. Raspberry Pi skickar sedan den mottagna strängen till Amazon Cloud Service med namnet Polly för att konvertera meningen som tas emot i textformat till talformat och streamar sedan det mottagna talet på högtalaren som är ansluten till Raspberry Pi via AUX -kabeln.

Detta projekt var bara ett bevis på konceptet och med bättre utrustning och planering och bättre kalibrerad för att upptäcka många andra gester och handrörelser. För närvarande är endast begränsad funktionalitet programmerad i detta projekt, till exempel för grundläggande gestdetektering och text till talutmatning.

Steg 3: Kod

Steg 4: Steg

1. Anslut flexsensorerna och accelerometern MMA8452Q till Arduino enligt det medföljande kretsschemat.

2. Dumpa programmet Final_Project.ino (finns i filen Arduino_code.zip) till Arduino.

3. Anslut Arduino till Raspberry Pi med en USB -kabel. (Kabeltyp A/B).

4. Starta Raspberry Pi, kopiera Raspberry_pi_code.zip -filen till Raspberry Pi och extrahera den. Anslut högtalaren till Raspberry Pi.

5. Kopiera dina AWS -kontouppgifter, dvs aws_access_key_id, aws_secret_access_key och aws_session_token till filen ~/.aws/credentials. Detta steg krävs för att kommunicera med AWS -molnet och för att använda AWS -tjänster.

6. Kör seria_test.py -programmet som finns i den extraherade mappen i steg 4.

7. Gör nu gesterna för att bilda en mening och gör sedan den speciella gesten (Håll fingrarna och handflatan raka och i linje med handflatan vänd bort från dig, och vrid sedan handleden så att den vänder nedåt så att din handflata nu är vänd mot dig och fingertoppen pekar nedåt mot dina fötter.) för att signalera att meningen är slutförd.

8. Håll koll på terminalen för användbar information.

9. Och lyssna på det konverterade talet som streamas på högtalaren.

Steg 5: Referenser

1.

2.

3.

4.

Rekommenderad:

Text till tal Klicka på ett ARMbasic Powered UChip och andra ARMbasic Powered SBC: 3 steg

Text till tal Klicka på ett ARMbasic Powered UChip och andra ARMbasic Powered SBC: Intro: God dag. Jag heter Tod. Jag är en flyg- och försvarsproffs som också är lite av en nörd i hjärtat. Inspiration: härstammar från epoken med uppringd BBS, 8-bitars mikrokontroller, Kaypro/Commodore/Tandy/TI-994A persondatorer, när R

Bubble Talk: Förvandla ditt tal till bubblor !: 6 steg (med bilder)

Bubble Talk: Turn Your Speech into Bubbles !:”quod, ut dicitur, si est homo bulla, eo magis senex (för om, som man säger, människan är en bubbla, desto mer är en gammal man)” - Marcus Terentius Varro (116 BC - 27 BC), De Re Rustica En tvålbubbla är flyktig. Det varar bara ett kort ögonblick och

Arduino TTS (text till tal): 3 steg (med bilder)

Arduino TTS (Text to Speech): Hej killar idag i den här självstudien kommer jag att lära dig hur du får ditt Arduino -samtal att prata utan någon extern modul. Här kan vi använda detta i många projekt som taltermometer, robotar och många fler. Så utan mycket slöseri med tid, låt oss börja detta projekt

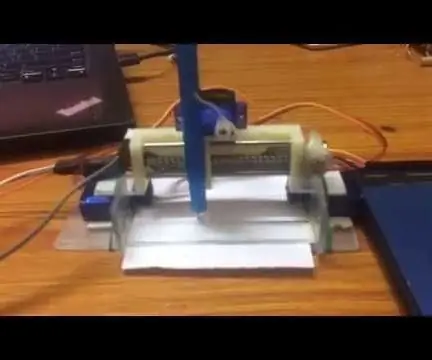

Enkel punktskriftsförfattare (tal till punktskrift): 8 steg (med bilder)

Enkel punktskriftsförfattare (tal till punktskrift): Hej alla, allt detta började med att göra en enkel XY -plotter efter att ha slutfört den framgångsrikt, jag tänkte utveckla ett enkelt tal till punktskriftskonverterare. Jag började söka på den online och oväntat var priserna för höga , det förstärkte mig

Text till tal Bullhorn: 4 steg

Text till tal Bullhorn: Det här är det enklaste sättet jag har hittat för att göra en effektiv text till tal bullhorn för en vän som är döv. För du vet, det gör dem ännu mer radiga. Det är inte ett särskilt tillfredsställande eller lärorikt byggprojekt, och det kräver att du köper några