Innehållsförteckning:

- Steg 1: Översikt över projektet

- Steg 2: Bakgrundsforskning

- Steg 3: Designkrav

- Steg 4: Teknisk design och utrustningsval

- Steg 5: Val av utrustning: Interaktionsmetod

- Steg 6: Val av utrustning: Mikrokontroller

- Steg 7: Val av utrustning: Sensorer

- Steg 8: Utrustningsval: Programvara

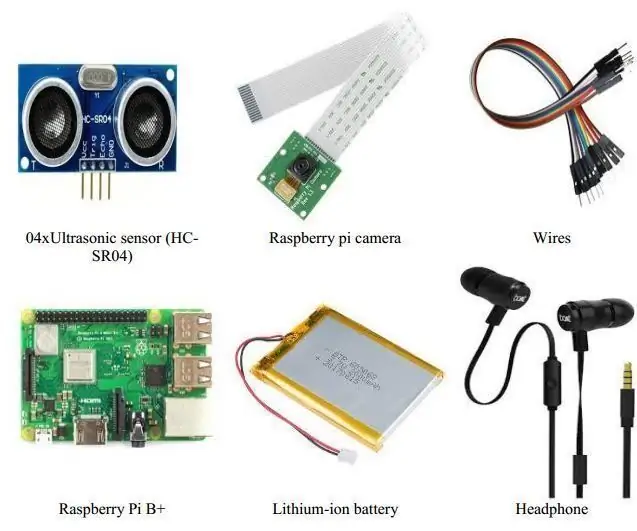

- Steg 9: Val av utrustning: Andra delar

- Steg 10: Systemutveckling: Skapa maskinvara Del 1

- Steg 11: Systemutveckling: Skapa maskinvarudel 2

- Steg 12: Systemutveckling: Programmering av systemets del 1

- Författare John Day day@howwhatproduce.com.

- Public 2024-01-30 12:45.

- Senast ändrad 2025-01-23 15:11.

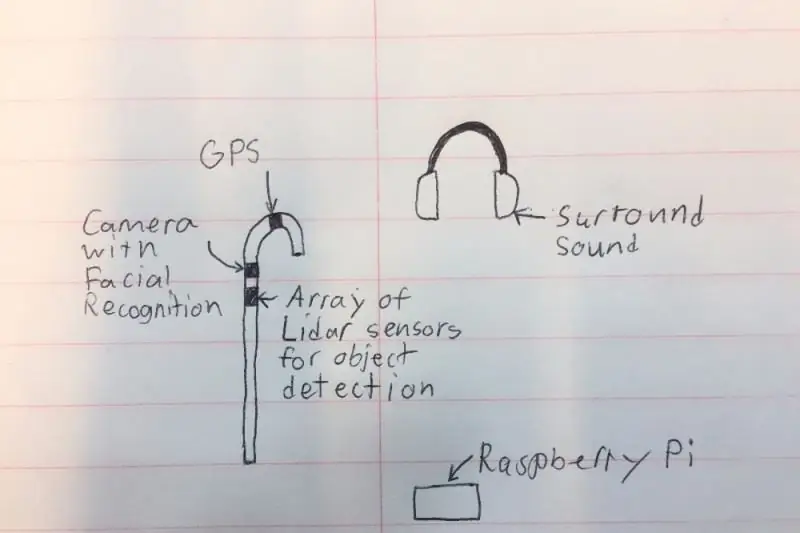

Jag vill skapa en intelligent "käpp" som kan hjälpa människor med synskador mycket mer än befintliga lösningar. Staven kommer att kunna meddela användaren om föremål framför eller på sidorna genom att ljuda i hörlurarna av surroundljudstyp. Staven kommer också att ha en liten kamera och LIDAR (Light Detection and Ranging) så att den kan känna igen föremål och personer i rummet och meddela användaren med hjälp av hörlurarna. Av säkerhetsskäl kommer hörlurarna inte att blockera allt ljud eftersom det kommer att finnas en mikrofon som kan filtrera bort alla onödiga ljud och hålla bilens horn och prata. Slutligen kommer systemet att ha en GPS så att den kan ge vägbeskrivningar och visa användaren vart den ska gå.

Vänligen rösta på mig i tävlingarna Microcontroller och Outdoor Fitness!

Steg 1: Översikt över projektet

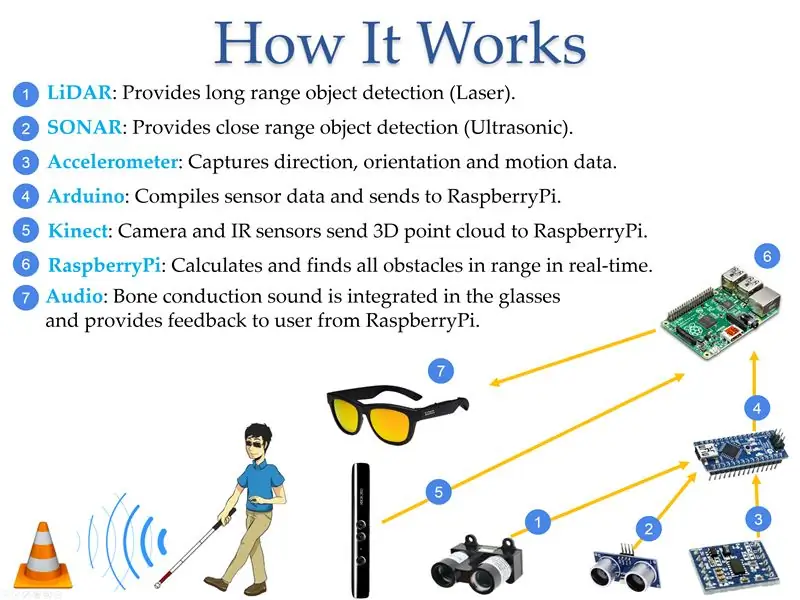

Enligt World Access for the Blind är fysisk rörelse en av de största utmaningarna för blinda. Att resa eller bara gå ner på en fullsatt gata kan vara mycket svårt. Traditionellt var den enda lösningen att använda den allmänt kända”vita käppen” som främst används för att skanna omgivningen genom att träffa hindren i närheten av användaren. En bättre lösning skulle vara en enhet som kan ersätta den synskadade assistenten genom att ge information om placeringen av hinder så att den blinda kan gå ut i okända miljöer och känna sig trygg. Under detta projekt utvecklades en liten batteridriven enhet som uppfyller dessa kriterier. Enheten kan detektera objektets storlek och plats med hjälp av sensorer som mäter objektens position i förhållande till användaren, vidarebefordra den informationen till en mikrokontroller och sedan konvertera den till ljud för att ge information till användaren. Enheten byggdes med hjälp av tillgänglig kommersiell LIDAR (Light Detection and Ranging), SONAR (Sound Navigation and Ranging) och datorsynsteknik kopplad till mikrokontroller och programmerad för att tillhandahålla den nödvändiga ljudinformationsutmatningen med hörlurar eller hörlurar. Detektionstekniken var inbäddad i en "vit käpp" för att indikera för användarens tillstånd och ge ytterligare säkerhet.

Steg 2: Bakgrundsforskning

År 2017 rapporterade Världshälsoorganisationen att det fanns 285 miljoner synskadade människor världen över, varav 39 miljoner är helt blinda. De flesta människor tänker inte på de problem som synskadade möter varje dag. Enligt World Access for the Blind är fysisk rörelse en av de största utmaningarna för blinda. Att resa eller bara gå ner på en fullsatt gata kan vara mycket svårt. På grund av detta föredrar många som är synskadade att ta med en synlig vän eller familjemedlem för att navigera i nya miljöer. Traditionellt var den enda lösningen att använda den allmänt kända”vita käppen” som främst används för att skanna omgivningen genom att träffa hindren i närheten av användaren. En bättre lösning skulle vara en enhet som kan ersätta den synskadade assistenten genom att ge information om placeringen av hinder så att den blinda kan gå ut i okända miljöer och känna sig trygg. NavCog, ett samarbete mellan IBM och Carnegie Mellon University, har försökt lösa problemet genom att skapa ett system som använder Bluetooth -beacons och smartphones för att vägleda. Lösningen var dock besvärlig och visade sig vara mycket kostsam för storskaliga implementeringar. Min lösning löser detta genom att eliminera behovet av externa enheter och genom att använda en röst för att vägleda användaren under hela dagen (Figur 3). Fördelen med att ha tekniken inbäddad i en "vit käpp" är att den signalerar resten av världen av användarens tillstånd som orsakar förändringar i beteendet hos omgivande människor.

Steg 3: Designkrav

Efter att ha undersökt den tillgängliga tekniken diskuterade jag möjliga lösningar med visionproffs om det bästa sättet att hjälpa synskadade att navigera i sin miljö. Tabellen nedan visar de viktigaste funktionerna som krävs för att någon ska kunna övergå till min enhet.

Funktion - Beskrivning:

- Beräkning - Systemet måste tillhandahålla en snabb behandling för utbytad information mellan användaren och sensorerna. Till exempel måste systemet kunna informera användaren om hinder framför som är minst 2 m bort.

- Täckning - Systemet måste tillhandahålla sina tjänster inomhus och utomhus för att förbättra kvaliteten på synskadade människors liv.

- Tid - Systemet ska fungera lika bra dagtid som nattetid.

- Område - Avståndet är avståndet mellan användaren och objektet som ska detekteras av systemet. Idealisk minsta räckvidd är 0,5 m, medan maximal räckvidd bör vara mer än 5 m. Ytterligare avstånd skulle vara ännu bättre men mer utmanande att beräkna.

- Objekttyp - Systemet ska upptäcka plötsliga utseende av objekt. Systemet ska kunna skilja på rörliga objekt och statiska objekt.

Steg 4: Teknisk design och utrustningsval

Efter att ha tittat på många olika komponenter bestämde jag mig för delar valda från de olika kategorierna nedan.

Pris på utvalda delar:

- Zungle Panther: $ 149,99

- LiDAR Lite V3: $ 149,99

- LV-MaxSonar-EZ1: $ 29,95

- Ultraljudssensor - HC -SR04: $ 3,95

- Raspberry Pi 3: $ 39,95

- Arduino: 24,95 dollar

- Kinect: 32,44 dollar

- Floureon 11.1v 3s 1500mAh: $ 19,99

- LM2596HV: $ 9,64

Steg 5: Val av utrustning: Interaktionsmetod

Jag bestämde mig för att använda röststyrning som metod för att interagera med enheten eftersom det kan vara svårt för en synskadad att ha flera knappar på en käpp, särskilt om vissa funktioner kräver en kombination av knappar. Med röststyrning kan användaren använda förinställda kommandon för att kommunicera med käppen vilket minskar potentiella fel.

Enhet: Fördelar --- Nackdelar:

- Knappar: Inget kommandofel när du trycker på höger knapp --- Det kan vara svårt att se till att de korrekta knapparna trycks in

- Röststyrning: Enkelt eftersom användaren kan använda förinställda kommandon --- Felaktigt uttal kan orsaka fel

Steg 6: Val av utrustning: Mikrokontroller

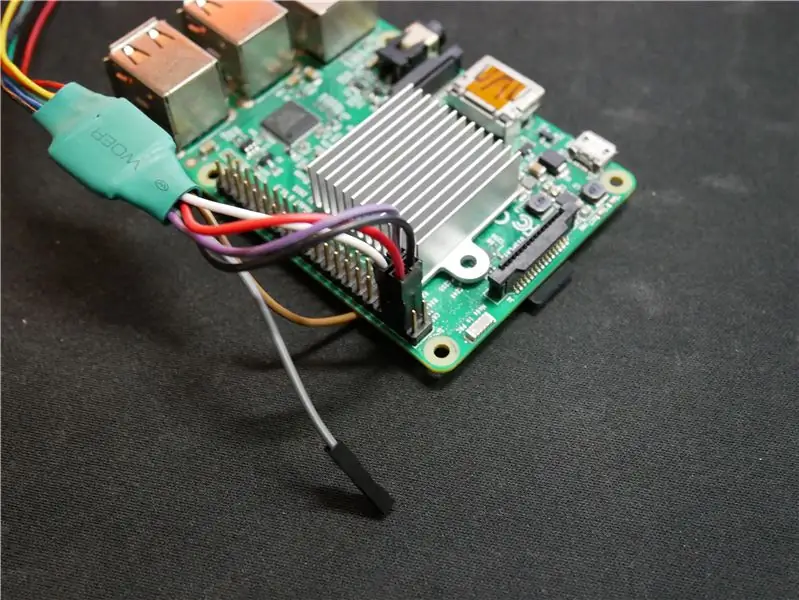

Enheten använde Raspberry Pi på grund av dess låga kostnad och tillräckliga processorkraft för att beräkna djupkartan. Intel Joule skulle ha varit det föredragna alternativet men priset skulle ha fördubblat kostnaden för systemet vilket inte skulle vara idealiskt den här enheten som är utvecklad för att ge ett lägre kostnadsalternativ för användare. Arduino användes i systemet eftersom det enkelt kan få information från sensorer. BeagleBone och Intel Edison användes inte på grund av lågt pris -prestanda -förhållande vilket är dåligt för detta lågkostnadssystem.

Mikrokontroller: Fördelar --- Nackdelar:

- Raspberry Pi: Har tillräckligt med processorkraft för att hitta hinder och har integrerat WiFi/Bluetooth --- Inte många alternativ för att ta emot data från sensorer

- Arduino: Ta enkelt emot data från små sensorer. dvs. LIDAR, ultraljud, SONAR, etc --- Inte tillräckligt med processorkraft för att hitta hinder

- Intel Edison: Kan bearbeta hinder snabbt med snabb processor --- Kräver extra utvecklarelement för att fungera för systemet

- Intel Joule: Har dubbla bearbetningshastigheten för någon av mikrokontrollerna på konsumentmarknaden hittills --- Mycket höga kostnader för detta system och svårt att interagera med GPIO för sensorinteraktion

- BeagleBone Black: Kompakt och kompatibel med sensorer som används i projektet med hjälp av General Purpose Input Output (GPIO) --- Inte tillräckligt med processorkraft för att effektivt hitta objekt

Steg 7: Val av utrustning: Sensorer

En kombination av flera sensorer används för att uppnå hög platsnoggrannhet. Kinect är huvudsensorn på grund av mängden yta den kan söka efter hinder samtidigt. LIDAR som står för LIGHT Detection and Ranging, är en fjärranalysmetod som använder ljus i form av en pulserad laser för att snabbt mäta avstånd från var sensorn är till objekt; den sensorn används eftersom den kan spåra ett område upp till 40 meter (m) bort och eftersom den kan skanna i olika vinklar kan den upptäcka om några steg går upp eller ner. SOUND Navigation And Ranging (SONAR) och ultraljudssensorer används som backup -spårning om Kinect missar en stolpe eller stöt i marken som kan utgöra en fara för användaren. Sensorn för 9 grader av frihet används för att spåra åt vilket håll användaren vänder sig så att enheten kan lagra informationen för högre noggrannhet direkt nästa gång personen går på samma plats.

Sensorer: Fördelar --- Nackdelar:

- Kinect V1: Kan spåra 3D-objekt med --- Endast en kamera för att upptäcka omgivningar

- Kinect V2: Har 3 infraröda kameror och en röd, grön, blå, djup (RGB-D) kamera för 3D-objektdetektering med hög precision --- Kan värma upp och kan behöva en kylfläkt och är större än andra sensorer

- LIDAR: Stråle som kan spåra platser upp till 40 m bort --- Behöver placeras mot objektet och kan bara titta i den riktningen

- SONAR: Stråle som kan spåra 5 m bort men inom långt avstånd --- Små föremål som fjädrar kan utlösa sensorn

- Ultraljud: Har en räckvidd på upp till 3 m och är mycket billigt --- Avstånd kan ibland vara felaktiga

- 9 grader av frihetssensor: Bra för att känna av användarens orientering och hastighet --- Om något stör sensorerna kan avståndsberäkningarna beräknas felaktigt

Steg 8: Utrustningsval: Programvara

Den valda programvaran för de första prototyperna som byggdes med Kinect V1 -sensorn var Freenect men den var inte särskilt exakt. Vid övergång till Kinect V2 och Freenect2 förbättrades spårningsresultaten avsevärt på grund av förbättrad spårning eftersom V2 har en HD -kamera och 3 infraröda kameror i motsats till en enda kamera på Kinect V1. När jag använde OpenNi2 med Kinect V1 var funktionerna begränsade och jag kunde inte styra några av enhetens funktioner.

Programvara: Fördelar --- Nackdelar:

- Freenect: Har en lägre kontrollnivå för att styra allt --- stöder bara Kinect V1

- OpenNi2: Kan enkelt skapa punktmolndata från informationsströmmen från Kinect --- stöder bara Kinect V1 och har inte stöd för lågnivåkontroll

- Freenect2: Har en lägre kontrollnivå för sensorstången --- Fungerar bara för Kinect V2

- ROS: Operativsystem perfekt för programmering av kamerafunktioner --- Måste installeras på ett snabbt SD-kort för att programvaran ska fungera

Steg 9: Val av utrustning: Andra delar

Litiumjonbatterier valdes på grund av att de var lätta, med hög effektkapacitet och laddningsbara. 18650 -varianten av litiumjonbatteriet har en cylindrisk form och passar perfekt in i käppprototypen. Den första prototypen är gjord av PVC -rör eftersom den är ihålig och minskar käppens vikt.

Steg 10: Systemutveckling: Skapa maskinvara Del 1

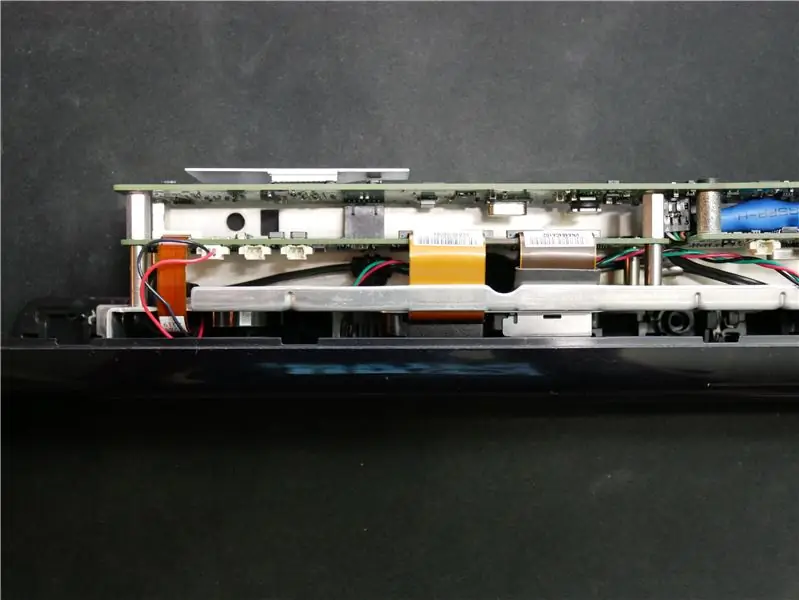

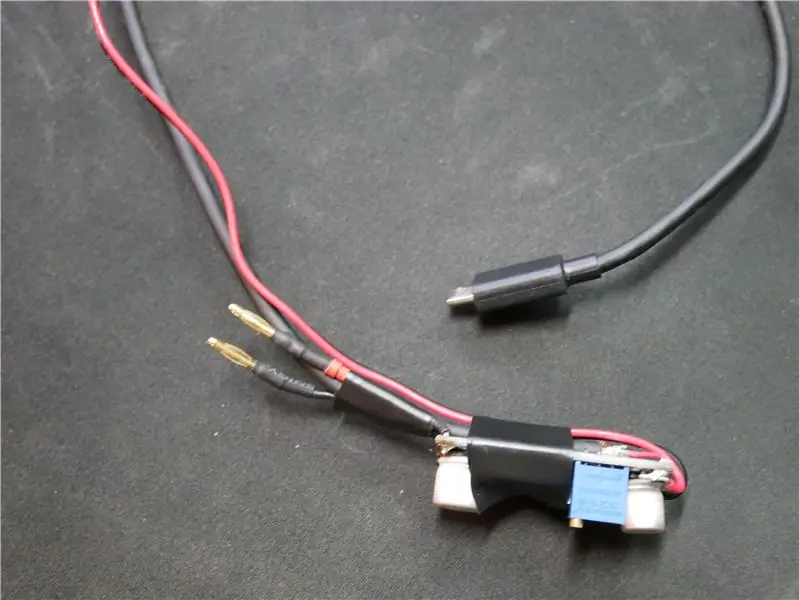

Först måste vi demontera Kinect för att göra det lättare och så att det passar inuti käppen. Jag började med att ta bort allt yttre hölje från Kinect eftersom plasten som väger mycket. Sedan fick jag klippa av kabeln så att basen kunde tas bort. Jag tog ledningarna från kontakten som visas på bilden och lödde dem till en usb -kabel med signalkablar och de andra två anslutningarna var för 12V ingångseffekt. Eftersom jag ville att fläkten inuti käppen skulle köras med full effekt för att kyla alla andra komponenter, klippte jag bort kontakten från fläkten från Kinect och kopplade 5V från Raspberry Pi. Jag gjorde också en liten adapter för LiDAR -kabeln så att den kan anslutas direkt till Raspberry Pi utan andra system däremellan.

Jag lödde av misstag den vita tråden till den svarta så titta inte på bilderna för kopplingsscheman

Steg 11: Systemutveckling: Skapa maskinvarudel 2

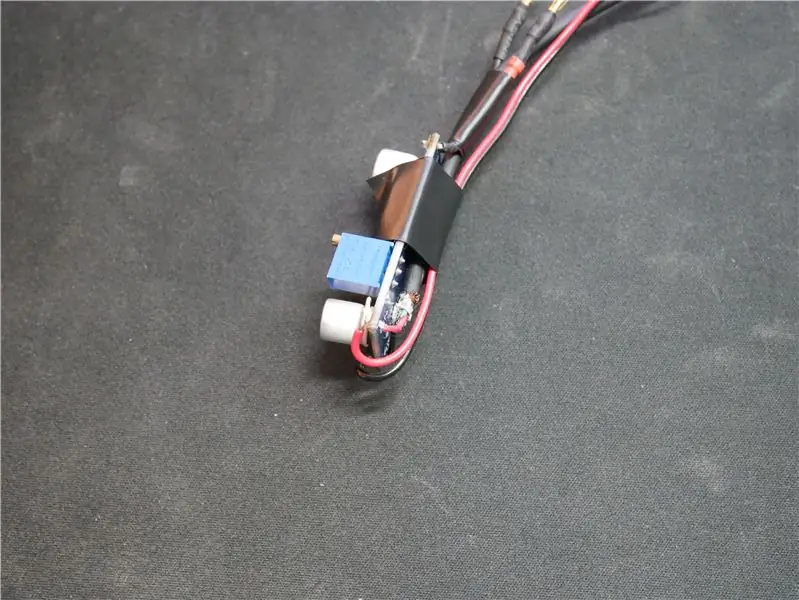

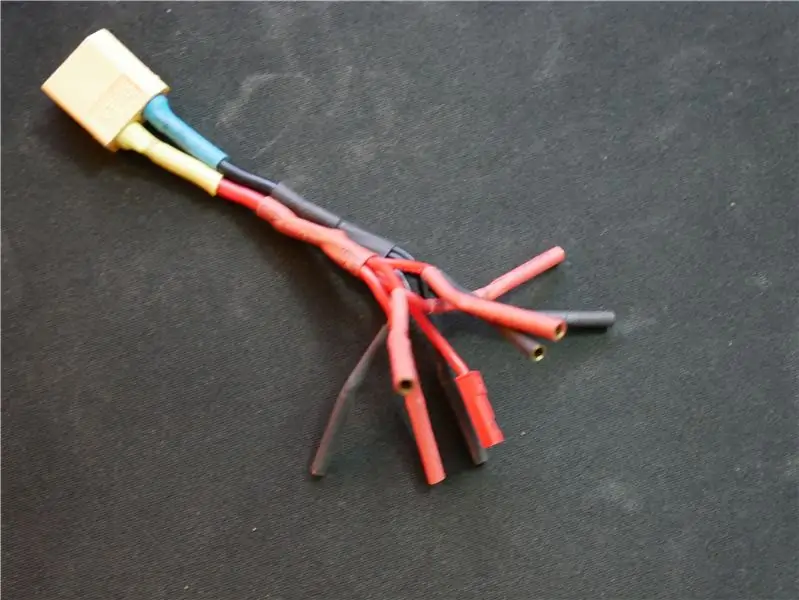

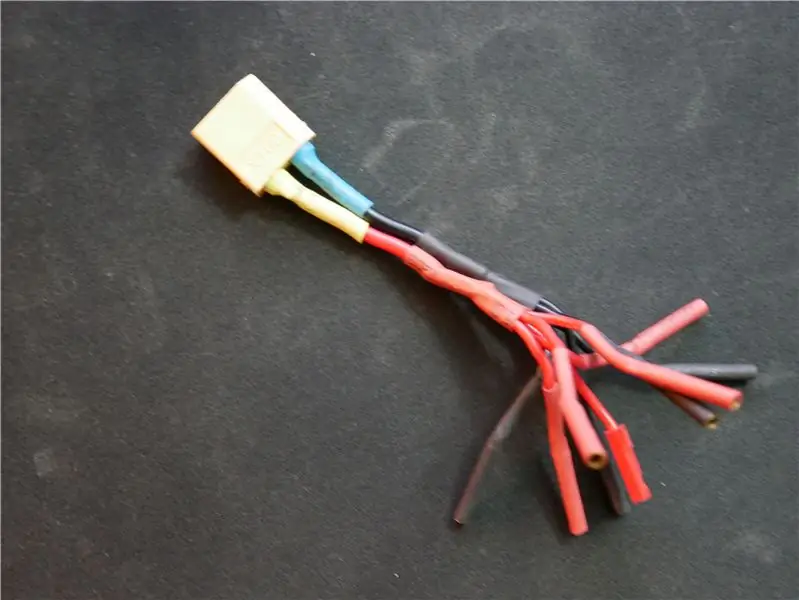

Jag skapade en regulatorbit för att ge ström till alla enheter som kräver 5V som Raspberry Pi. Jag ställde in regulatorn genom att sätta en mätare på utgången och justera motståndet så att regulatorn skulle ge 5,05V. Jag lägger det lite högre än 5V eftersom batterispänningen med tiden sjunker och påverkar utspänningen något. Jag gjorde också en adapter som gör att jag kan driva upp till 5 enheter som kräver 12V från batteriet.

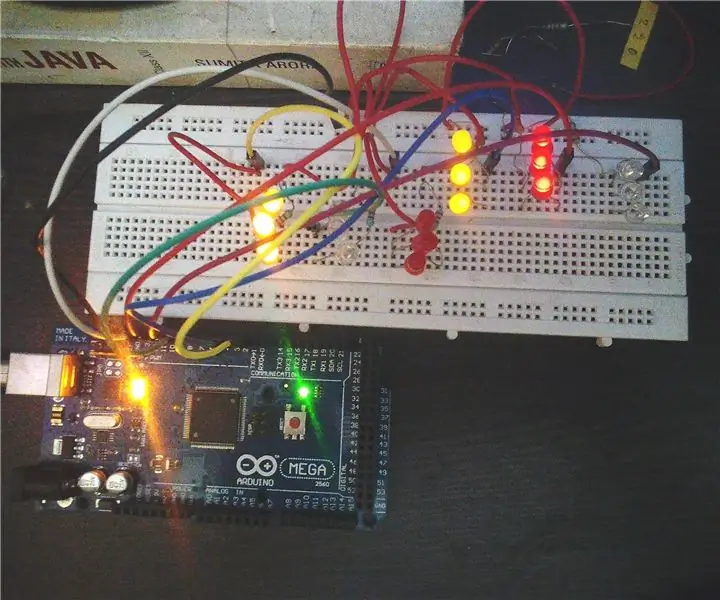

Steg 12: Systemutveckling: Programmering av systemets del 1

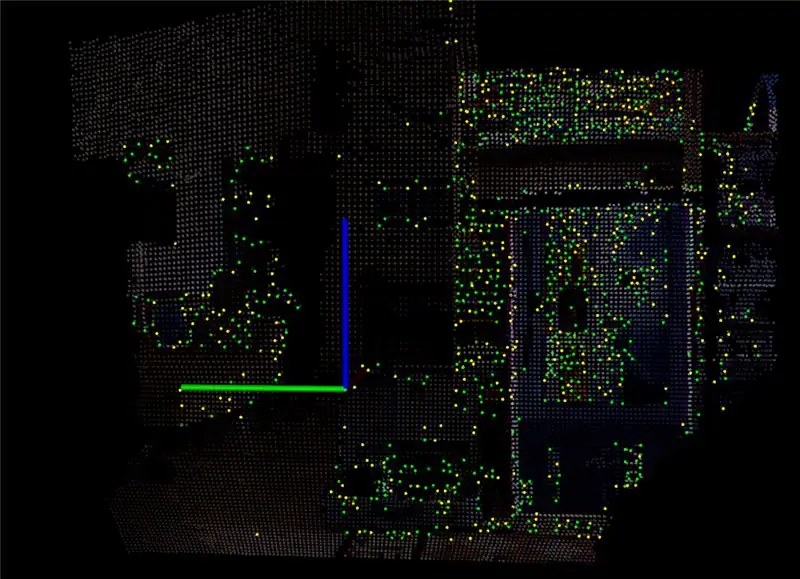

En av de mest utmanande delarna av detta system är programmeringen. När jag först fick Kinect att leka med det installerade jag ett program som heter RTAB Map som tar dataströmmen från Kinect och konverterar det till ett punktmoln. Med punktmolnet skapade det en 3D -bild som kan roteras så se djupet på var alla objekt är. Efter att ha lekt med det ett tag och justerat alla inställningar bestämde jag mig för att installera lite programvara på Raspberry Pi så att jag kan se dataströmmen från Kinect. De två sista bilderna ovan visar vad Raspberry Pi kan producera med cirka 15-20 bilder per sekund.

Rekommenderad:

Hacka Hexbug Spider XL för att lägga till datorsyn med en Android -smartphone: 9 steg (med bilder)

Hacka Hexbug Spider XL för att lägga till Computer Vision med en Android -smartphone: Jag är ett stort fan av den ursprungliga Hexbug ™ Spindel. Jag har ägt över ett dussin och hackat dem alla. När som helst går en av mina söner till en kompis ’ födelsedagsfest får vännen en Hexbug ™ spindel i present. Jag har hackat eller

Vandringsguide för att förbättra rörelsen för synskadade: 6 steg

Walking Guide för att förbättra rörligheten för synskadade: Målet med den instruerbara är att utveckla en vandringsguide som kan användas av funktionshindrade, särskilt synskadade. Den instruerbara avser att undersöka hur vandringsguiden kan användas effektivt, så att designkraven

Autonom drönare med infraröd kamera för att hjälpa första svarare: 7 steg

Autonom drönare med infraröd kamera för att hjälpa första svarare: Enligt en rapport från Världshälsoorganisationen dödar varje år naturkatastrofer cirka 90 000 människor och drabbar närmare 160 miljoner människor världen över. Naturkatastrofer inkluderar jordbävningar, tsunamier, vulkanutbrott, jordskred, orkaner, fl

DIY MusiLED, musiksynkroniserade lysdioder med ett klick Windows och Linux-applikation (32-bitars och 64-bitars). Lätt att återskapa, lätt att använda, lätt att porta .: 3 steg

DIY MusiLED, musiksynkroniserade lysdioder med ett klick Windows och Linux-applikation (32-bitars och 64-bitars). Lätt att återskapa, lätt att använda, lätt att porta .: Detta projekt hjälper dig att ansluta 18 lysdioder (6 röda + 6 blå + 6 gula) till ditt Arduino-kort och analysera datorns ljudkortets realtidsignaler och vidarebefordra dem till lysdioderna för att tända dem enligt slageffekterna (Snare, High Hat, Kick)

Övertyga dig själv om att bara använda en 12V-till-AC-omriktare för LED-ljussträngar istället för att koppla om dem för 12V: 3 steg

Övertyga dig själv om att bara använda en 12V-till-AC-linjeomvandlare för LED-ljussträngar istället för att koppla om dem för 12V: Min plan var enkel. Jag ville klippa upp en väggdriven LED-ljussträng i bitar och sedan dra om den för att gå av 12 volt. Alternativet var att använda en kraftomvandlare, men vi vet alla att de är fruktansvärt ineffektiva, eller hur? Höger? Eller är de det?