Innehållsförteckning:

- Författare John Day day@howwhatproduce.com.

- Public 2024-01-30 12:37.

- Senast ändrad 2025-01-23 15:10.

Detta projekt syftar till att fånga det mänskliga ögats rörelse och visar dess rörelse på en uppsättning LED -lampor som är placerade i form av ett öga. Denna typ av projekt kan potentiellt ha många användningsområden inom robotik och specifikt humanoider. Som ett exempel kan en person projicera sina ögon på ansiktet på en robot som interagerar med andra människor för vilket ändamål som helst. Detta kan ge en robot ett mer livligt utseende eftersom ögonen efterliknar någons faktiska ögonrörelse. Detta projekt innebär bara att visa ett mänskligt öga på ett LED -öga, så jag är spänd på att se vilka andra idéer människor har för att utveckla detta projekt ytterligare.

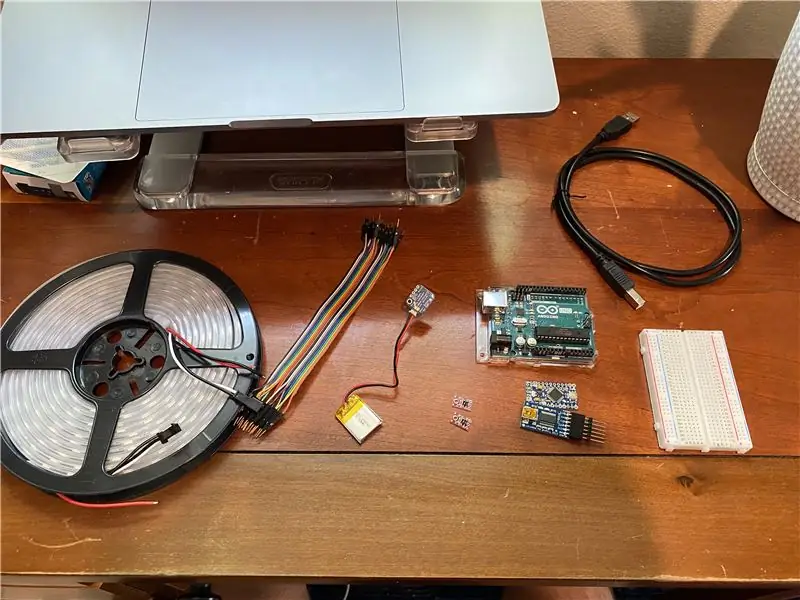

Tillbehör

1. Arduino Uno -kort (se till att köpa en USB -kabel för att ansluta till datorn)

store.arduino.cc/usa/arduino-uno-rev3

2. Brödbräda (behöver inte en mycket stor; gör anslutning av ledningar enklare)

www.pololu.com/product/351

3. Adafruit LiIon/LiPoly ryggsäckstillägg för Pro Trinket/ItsyBitsy och 3.7V batteri

www.adafruit.com/product/2124

4. NeoPixel LED Strip (köp hela rullen)

www.adafruit.com/product/1138?length=4

5. QTR-1A reflektionssensor

www.pololu.com/product/2458

6. Kabelpaket: hane/hane (gör anslutning av komponenter enklare)

www.adafruit.com/product/759

7. Alla glasögonramar (glasögon, solglasögon etc. Se bilder för referens)

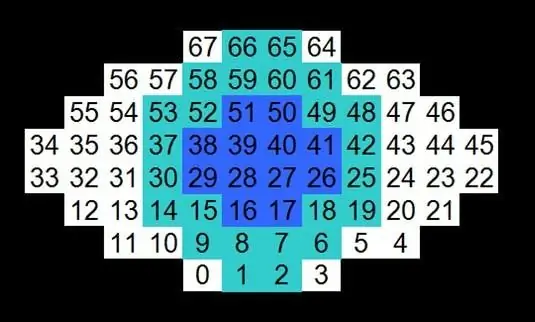

Steg 1: Layout & Wire LED -lampor i ögonform

Baserat på bilderna som bifogas detta steg, koppla LED -lamporna i den ordning som visas. Lysdioderna kan läggas platta på en yta eller fästas med tejp på ett sfäriskt föremål för att bättre representera en faktisk ögonglob.

Steg 2: Skriv Arduino -kod och ladda upp till styrelsen

Den bifogade filen för detta steg innehåller all kod som krävs för att visa ögonrörelsen på lysdioderna. Det finns två bibliotek som ingår i koden och de finns på Github -länkarna nedan. Lek med koden och se vilka andra coola funktioner som kan implanteras. När koden är klar, se till att den kompileras och ladda upp den till Arduino Uno -kortet.

QTRsensors.h:

Adafruit_NeoPixel.h:

Förklaring av koden:

När iris närmar sig en sensor minskar det reflekterade ljuset och sensorvärdet ökar. Omvänt, när irisen rör sig bort, ökar det reflekterade ljuset och sensorvärdet för fotoreflektorn minskar. Höger och vänster rörelse för pupillen i LED -ögongloben känner av ökningen och minskningen av ett sensorvärde och styr det. När de blinkar minskar båda sensorvärdena, så om de två sensorvärdena minskar samtidigt, kommer ögonlocken på LED -ögongloben att sjunka.

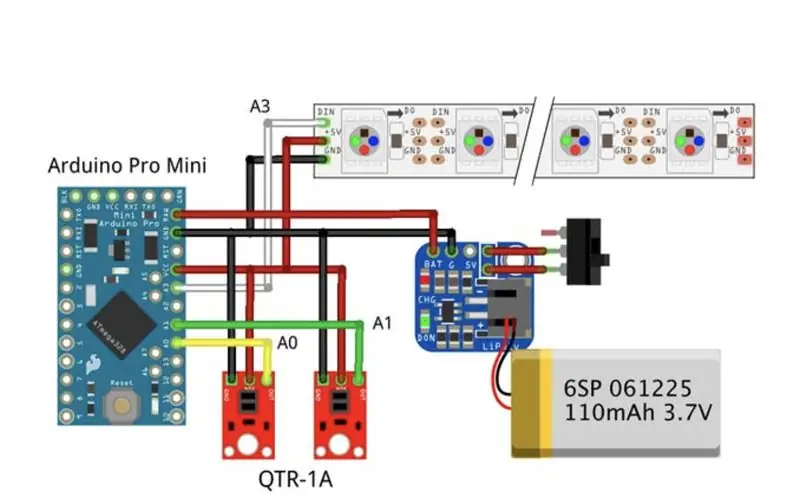

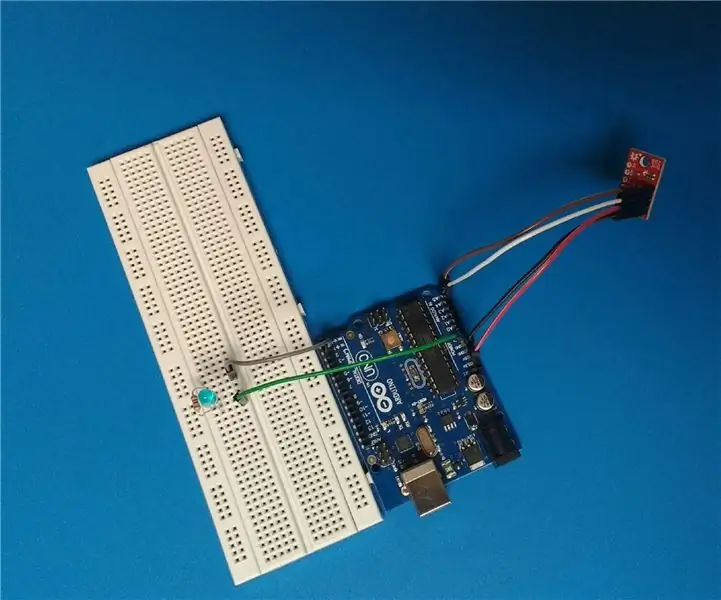

Steg 3: Anslut sensorer/komponenter

Baserat på den bifogade bilden, koppla upp varje komponent till Arduino Uno -kortet. En brödbräda kan användas för att göra anslutningarna enklare, men behövs inte nödvändigtvis. Lödning av trådarna till komponenterna fungerar också.

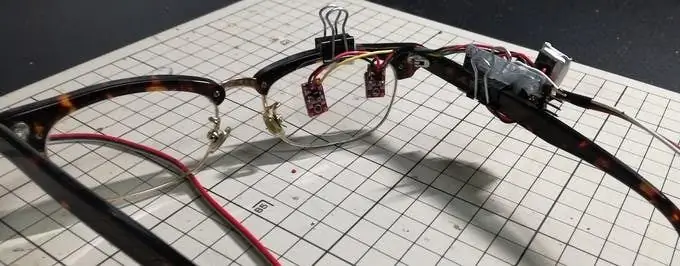

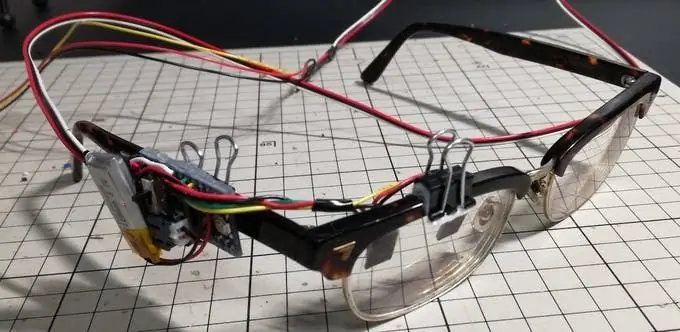

Steg 4: Fäst sensorer/ledningar på glasögon

De två QTR - 1A -sensorerna är placerade på ett avstånd av ungefär bredden på ögat på en av glasögonen. Det är den enda utrustningen som behöver finnas på den platsen. Resten kan fästas på glasögonen som du vill. Kom bara ihåg att sensorerna måste placeras på linsen framför ögat. Vissa mindre positionsjusteringar kan behövas baserat på hur olika människors ansiktsstrukturer passar glasögonen.

Steg 5: Videopresentation om projektet

Detta är en video av min presentation av projektet för min Humanoids -klass vid Carnegie Mellon University. I videon diskuterar jag en del av projektets inspiration och syfte. Dessutom förklarar jag detaljerna om hur projektet ska slutföras, samt förklarar en del av Arduino -koden. Jag visar också hur det slutliga resultatet av projektet ska se ut mot slutet av videon.

Steg 6: Hur man förbättrar mina resultat

Om du letar efter en verklig utmaning rekommenderar jag starkt att du tar det här projektet och försöker något lite annorlunda för att förbättra/lägga till det. Detta projekt är en bra utgångspunkt för mer ambitiösa och utmanande projektidéer. För människor som är intresserade av att ta detta projekt till nästa nivå har jag funderat på några sätt att göra det. Jag kommer att lista dessa idéer nedan:

1. Kopiera detta projekt på den andra linsen så att båda mänskliga ögonbollar kan visas på två uppsättningar lysdioder.

2. Tillägg till idé #1, men ta sedan reda på ett sätt att projicera munrörelsen på lysdioder.

3. Tillägg till idé #2, men ta sedan reda på hur man projicerar på hela ansiktet på en uppsättning lysdioder (ögon, mun, näsa, ögonbryn)

4. Hitta en annan kroppsdel vars rörelse kan avkännas och sedan visas på lysdioder (handrörelse, armrörelse, etc.)

Rekommenderad:

Head Motion Tracking System för VR: 8 steg

Head Motion Tracking System för VR: Jag heter Sam KODO, i den här handledningen kommer jag att lära dig steg för steg hur du använder Arduino IMU -sensorer för att bygga head tracking system för VR. I detta projekt behöver du: - En LCD -display HDMI : https: //www.amazon.com/Elecrow-Capacitive-interfac…- En

Hur man använder Detect Human HC-SR501: 9 steg

Hur man använder Detect Human HC-SR501: En handledning för att utveckla Detect Human HC-SR501 med skiiiD

BME280, Human Contact Detector: 5 steg

BME280, Human Contact Detector: Hej och välkommen till Human Contact Detector -projektet med BME280 -sensorn från Sparkfun. Detta projekt kommer att använda BME280: s temperatursensor för att upptäcka människokontakt genom temperaturförändringen

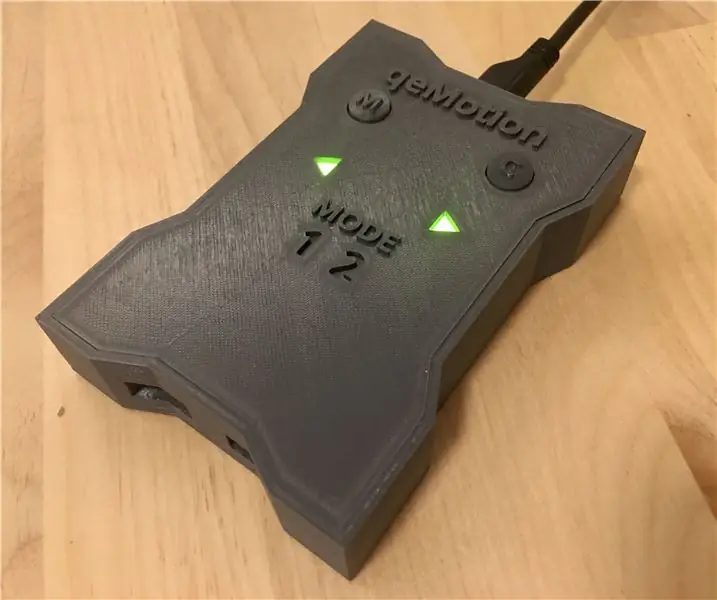

QeMotion - Motion Tracking för varje headset !: 5 steg (med bilder)

QeMotion - Motion Tracking för varje headset !: Översikt: Med den här enheten kan du använda din huvudrörelse för att utlösa händelser i i princip alla videospel. Det fungerar genom att spåra rörelsen i ditt huvud (eller headsetet det med avseende på) och utlösa tangentbordspressar för vissa rörelser. Så din komp

Eye Guardian: Sound Triggered Eye Protection: 9 steg (med bilder)

Eye Guardian: Sound Triggered Eye Protection: Eye Guardian är ett Arduino-drivet, High Decibel kontinuerligt ljud som utlöser ögonskydd. Den upptäcker ljud från tung utrustning och sänker skyddsglasögonen medan utrustningen används. Kontur I det första steget kommer jag att förklara Inspirati